L'uomo che si è avvelenato con ChatGPT e l'insidia della gratuità

Fidandosi di ChatGPT un uomo ha contratto una malattia del secolo scorso. Forse con una nuova versione di ChatGPT non sarebbe successo, eppure...

Nel mio ultimo video ho raccontato di un uomo che avendo letto degli effetti negativi del consumo di sale ha ben pensato di chiedere a ChatGPT come eliminarlo.

L'uomo trovava online solo consigli su come ridurlo –perché infatti non andrebbe eliminato– e dunque si sarebbe rivolto al chatbot che avrebbe consigliato il bromuro di sodio come sostituto.

Voglio fare un esperimento per essere meno dipendente dai social, quindi proverò ad accompagnare qui i video brevi a qualche riga scritta, in modo che chiunque possa fruirne anceh senza dovermi trovare sui social.

Ditemi se vi piace, vediamo.

Forse non ricordate dove sia il bromuro di sodio nel vostro supermercato di fiducia, se nello scaffale prima o dopo i sughi pronti. c'è un motivo:

il bromuro non è fatto per essere mangiato. Ma anzi, la sua esposizione può portare al bromismo, che nel secolo scorso era causa di circa un ricovero psichiatrico su dieci.

L'uomo di cui parliamo, la cui vicenda è uscita sugli Annals of Internal Medicine, si presenta al pronto soccorso ipotizzando che il vicino lo stia avvelenando. Dopo un ricovero forzato che gli permette di stabilizzarsi confessa ai medici la sua fantasiosa dieta, e si arriva alla diagnosi di bromismo.

Ci sono tre cose che possiamo imparare da questo episodio:

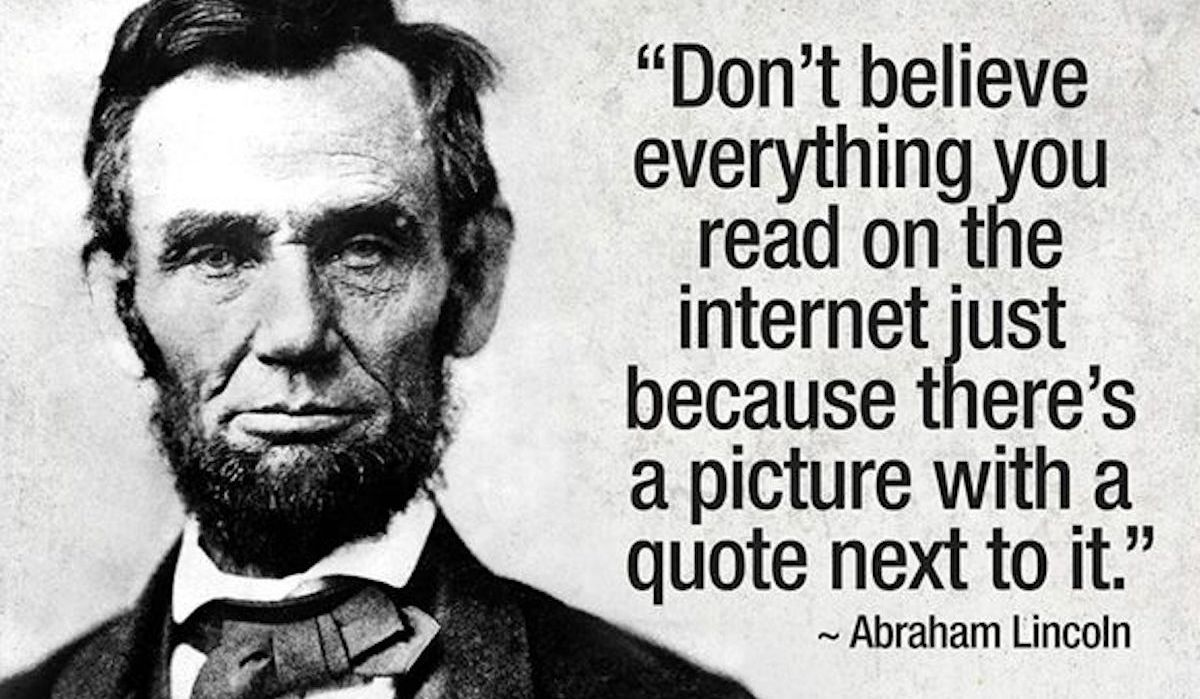

La prima è, ripetiamo insieme, che non ti puoi fidare di ChatGPT. Certamente possiamo fare domande, usarlo per fare ricerche, come faccio io stesso regolarmente. Ma come abbiamo imparato a non fidarci alla cieca di tutto quello che leggiamo online, dobbiamo capire questo strumento con i suoi punti deboli e forti.

ChatGPT risponde in base ai dati che ha ricevuto nel training: è in buona approssimazione un mischione di ciò che è popolare su internet. E siccome non è cosciente del testo che genera può fare collegamenti inadatti al contesto, come quando gli chiediamo una battuta e traduce in italiano un gioco di parole inglese, perché non sa che non funzionerà.

Fa parte del problema delle allucinazioni. La soluzione è semplice: o dobbiamo saper abbastanza sul tema in questione per valutare noi la risposta di ChatGPT, oppure la dobbiamo usare come trampolino per avere conferma da un'altra fonte più stabile. Su questo punto credo ottimisticamente che se conosciamo lo strumento lo possiamo usare in modo utile. I hope.

La seconda riflessione è che ci troviamo in un curioso trade-off: quando questi strumenti migliorano diventiamo più vulnerabili. È più o meno il paradosso dell'affidabilità dell'AI:

se un modello AI sbagliasse nel 50% delle risposte sarebbe facile ricordare che non ci possiamo fidare, perché vedremmo continuamente degli errori.

Come dire, ai tempi di GPT-2 era "facile" non fidarsi del testo generato (al netto del fatto che non lo conoscesse nessuno e che non avesse la modalità "chat").

Immaginiamo ora un altro modello, decisamente migliore –ma non perfetto– e ipotizziamo che solo 1 volta su 10 generi una risposta insensata invece delle 5/10 di prima.

Sarebbe naturale in questo secondo caso venire progressivamente portati a fidarci di quello che viene generato senza ricontrollare, perché molto spesso funziona davvero.

Questo è il rischio che viviamo oggi: i modelli migliorano, ed è un bene. Ma le allucinazioni sono una feature strutturale dei modelli di linguaggio, e sono ancora qui, in barba a chi anni fa diceva che entro pochi mesi sarebbero state "risolte".

Le allucinazioni sono date dall'inequivocabile fatto che i modelli di linguaggio non possono conoscere cosa è reale, perché non hanno esperienza fuori dalla distribuzione statistica dei testi che gli diamo. E quindi?

Dobbiamo aggrapparci saldamente, anche quando la corrente sembra trascinarci, e mantenere la lucidità della fragilità di ciò che genera un chatbot. Non si tratta di rifiutarli necessariamente in toto, ma di non cedere a questa pigrizia cognitiva: anche se 90 volte su 100 generano il testo corretto dobbiamo mantenere la consapevolezza che strutturalmente non possono garantirci l'esattezza, e questo vale anche quando vediamo allegati i link, che dobbiamo sempre controllare.

L'altro problema: il potere della gratuità

Benvenute alle persone che arrivano avendo visto il video e hanno skippato fino ad ora! Arriviamo alla terza riflessione.

Come dicevamo, i modelli AI migliorano di versione in versione; certi problemi rimangono, ma le aziende promettono di renderli sempre più sicuri e potenti.

Aneddoticamente, ChatGPT con GPT-5 ora mi risponde correttamente che il bromuro non va bene per sostituire il sale e ne distingue gli usi.

Ma cosa succede allora se certi modelli o certe funzionalità dei modelli sono bloccate dietro al pagamento di un abbonamento?

Al momento con GPT-5 solo gli utenti Plus o Pro possono scegliere deliberatamente se arrivare la modalità Thinking, che in certe situazioni fa generare risposte più elaborate.

Gli utenti free, oltre ad avere un limite all'utilizzo, possono solo assecondare la scelta automatica del sistema di quando attivare la modalità Thinking o meno.

Questo è...ovvio. È totalmente banale che chi paga abbia funzionalità in più e un prodotto migliore, non stupisce nessuno e più o meno tutti i prodotti (tech e non) funzionano in questo modo.

Riproponiamo dunque una dinamica di disuguaglianza, se vogliamo di classe: chi può permetterselo ottiene l'AI migliore, le risposte più accurate e riesce a velocizzare maggiormente il proprio lavoro.

Come dicevo, questa è una ovvietà, ma penso valga la pena evidenziarlo: la narrazione delle aziende AI è spesso che questi strumenti "democratizzino" e rendano più accessibili certi risultati.

In una certa misura questo è vero (pensiamo ai sottotitoli: oggi per me grazie all'AI è facilissimo mettere i sottotitoli ai miei video).

Ma sotto altri punti di vista questo non cancella le dinamiche gerarchiche del nostro mondo capitalistico: chi ha già più risorse continuerà ad avere vantaggi maggiori con l'AI, a patto di usarla adeguatamente.

Questo è vero anche a livello macroscopico: i sistemi AI funzionano meglio per lingue come l'inglese o l'italiano per cui c'è molto materiale per l'addestramento, mentre è più difficile per le lingue a basse risorse, per esempio diverse lingue del continente africano di cui ci sono meno dati.

Ed è vero anche individualmente se certe feature o un numero maggiore di messaggi sono disponibili solo agli utenti paganti.

Di nuovo, dato il nostro sistema economico è ovvio che questo accada. E anzi, non è male che per esempio ChatGPT offra anche agli utenti free il suo ultimo e migliore modello GPT-5. Non sto insomma dicendo necessariamente che dobbiamo radere tutto al suolo. (unless...)

Il mio spunto, per concludere, è piuttosto quello di ricordare che ad oggi questi sistemi sono comunque privati e chiusi, by design. Teniamolo a mente quando qualcuno ci vende un sogno di elevazione collettiva.

Quanto possiamo collettivamente affidarci a loro senza renderci troppo dipendenti?

Se OpenAI o Google o Microsoft o Anthropic decidessero unilateralmente di cambiare totalmente il costo di accesso ai loro sistemi, quanto potere abbiamo noi? (o che succede se ChatGPT va in down?)

E dunque quanto dovremmo regolamentare tutto ciò? Forse se vogliamo sognare un futuro diverso dobbiamo occuparci anche di come costruire le tecnologie con i valori che vogliamo.

Eventismi

Se siete a Roma, tra l'altro, domenica 7 alle 16 mi trovate a Terra, la festa nazionale di AVS, per "IMMAGINIAMO IL DOMANI, COSTRUIAMO L’OGGI" un panel con l'Unione Giovani di Sinistra e i Giovani Europeisti Verdi a parlare di come rapportarci all'AI a livello lavorativo e sociale, e come immaginare la nostra costruzione della tecnologia per un domani. Qui trovate programma completo della festa!

Linkini interessanti

🍳 Cosa c'è nella cucina di Sam Altman, CEO di OpenAI? Pezzo divertentissimo del Financial Times che analizza la cucina di Sam Altman e le sue molte bottiglie di olio d'oliva.

🚒 Ho scoperto tramite, ovviamente, TikTok, che in USA esiste un programma per le scuole superiori in cui simulano delle morti da incidenti stradali. Fanno questo evento pubblico in cui simulano un incidente, fanno dei finti funerali usando i veri nomi degli studenti "morti" e a volte ci sono degli altri studenti che interpretano il tristo mietitore che va a scegliere le sue vittime e io non ci posso credere e OVVIAMENTE, OVVIAMENTE vi cito il paragrafo Effectiveness da Wikipedia (grassetti miei):

Effectiveness

Studies that have tracked students before and after the Every 15 Minutes program have shown that the program may have a favorable short-term effect on students' stated attitudes but no effect on actual behavior.[4]

To date, no study has shown that the Every 15 Minutes program actually leads to a decrease in teen drinking and driving rates.

This has led to charges that the Every 15 Minutes program is similar to the controversial DARE anti-drug program in that it produces the appearance of addressing the problem but does not produce the desired change in behavior.

It has been long known that these types of approaches (i.e. scare tactics, dramatizations) that attempt to increase awareness or improve knowledge are ineffective.

raga ma come si può pensare che abbia senso, wow

🪩 Sarah McCreanor, @smacmccreanor e la sua stupenda performance in cui imita i video in cui vengono messi oggetti di vario tipo sotto le presse, amazing.

🧽 Barbero racconta Spongebob, tipo, di @andreamillais

🧑⚕️ In USA, RFK Jr, capo del dipartimento della salute del governo Trump, vuole focalizzarsi sulla nutrizione e sul far mangiare meglio le persone americane. Allo stesso tempo, vengono fatti ampi tagli ai programmi che aiutano le persone a mangiare meglio. Per ricordare le contraddizioni di certe narrazioni politiche.

Allora; non sono riuscito a farla uscire sabato, quindi questa lettera esce mezza settimana in ritardo. Per me è comunque un successo (gif umoristica di persona che suda). Prossima settimana ci riprovo, ci vediamo giovedì e parliamo di un casino che è successo in USA tra giornalismo e politica, mi sa.

E come sempre, grazie per la lettura 👋

Comments ()