“Il Foglio AI” è un esperimento raccapricciante, sciocco, e interessante.

Il Foglio è il primo quotidiano a sperimentare con una edizione stampata totalmente "scritta da AI". È un esperimento che vuole essere irriverente e provocatorio rispetto al mondo del giornalismo, e penso che riesca a lanciare alcuni spunti interessanti. Ma commette alcune leggerezze problematiche.

Oggi analizziamo un primo esperimento di pubblicazione "mainstream" fatta usando estensivamente un modello AI basato su LLM.

Ci sarebbe anche l'altro grande caso di questi giorni: Ipnocrazia, il finto-vero-libro dell'autore immaginario-non-immaginario Xun, rivelatosi essere un progetto di Andrea Colamedici "in dialogo con l'AI".

Ipnocrazia l'ho preso alla sua presentazione e letto qualche tempo fa. Ma ci sto ancora ruminando, quindi rimandiamo alla prossima, ok?

Dunque, eccoci, il Foglio AI, primo quotidiano stampato fatto con AI. La testata non è nuova al tema, visto che anni fa aveva già pubblicato online degli articoli generati con AI.

In questo caso, come spiega il direttore Cerasa, i giornalisti scrivono a ChatGPT chiedendogli un articolo, questo viene generato in risposta e controllato. Dopodiché, come un pezzo vero, si mette su carta et voilà, escono 4 pagine di giornale 4 volte a settimana, per un esperimento di un mese che si è appena concluso.

Degli esperimenti sono senz'altro un fan. Per esempio penso che uno degli aspetti positivi dei social è proprio quanto renda più semplice sperimentare, pubblicare roba strana, che magari fa schifo o magari è incredibile, e va bene così.

E allora questo è un esperimento bello o uno brutto?

Non appena ho visto la notizia del Foglio AI sono corso in edicola.

Beh, circa 10 ore dopo visto che ormai era sera. Ho acquistato quindi il secondo numero, dopo aver fatto venire dubbi all'edicolante chiedendo conferma che ci fosse l'inserto AI.

Mi metto comodo in terrazzo, inizio a leggere, e dopo poche righe comincio già a infastidirmi.

Parliamo degli aspetti problematici di questo esperimento, andando in ordine di gravità, ma spezzeremo poi anche delle proverbiali lance a favore.

Non mi vergogno, come ultima premessa, di dire che specialmente su certi argomenti (come cambiamento climatico o questione palestinese) non ho apprezzato storicamente la linea editoriale del Foglio. Nasconderlo sarebbe stato scorretto, ma farò del mio meglio per essere onesto nell'analisi. A voi se credermi o meno.

I bias e la presunta neutralità della tecnologia

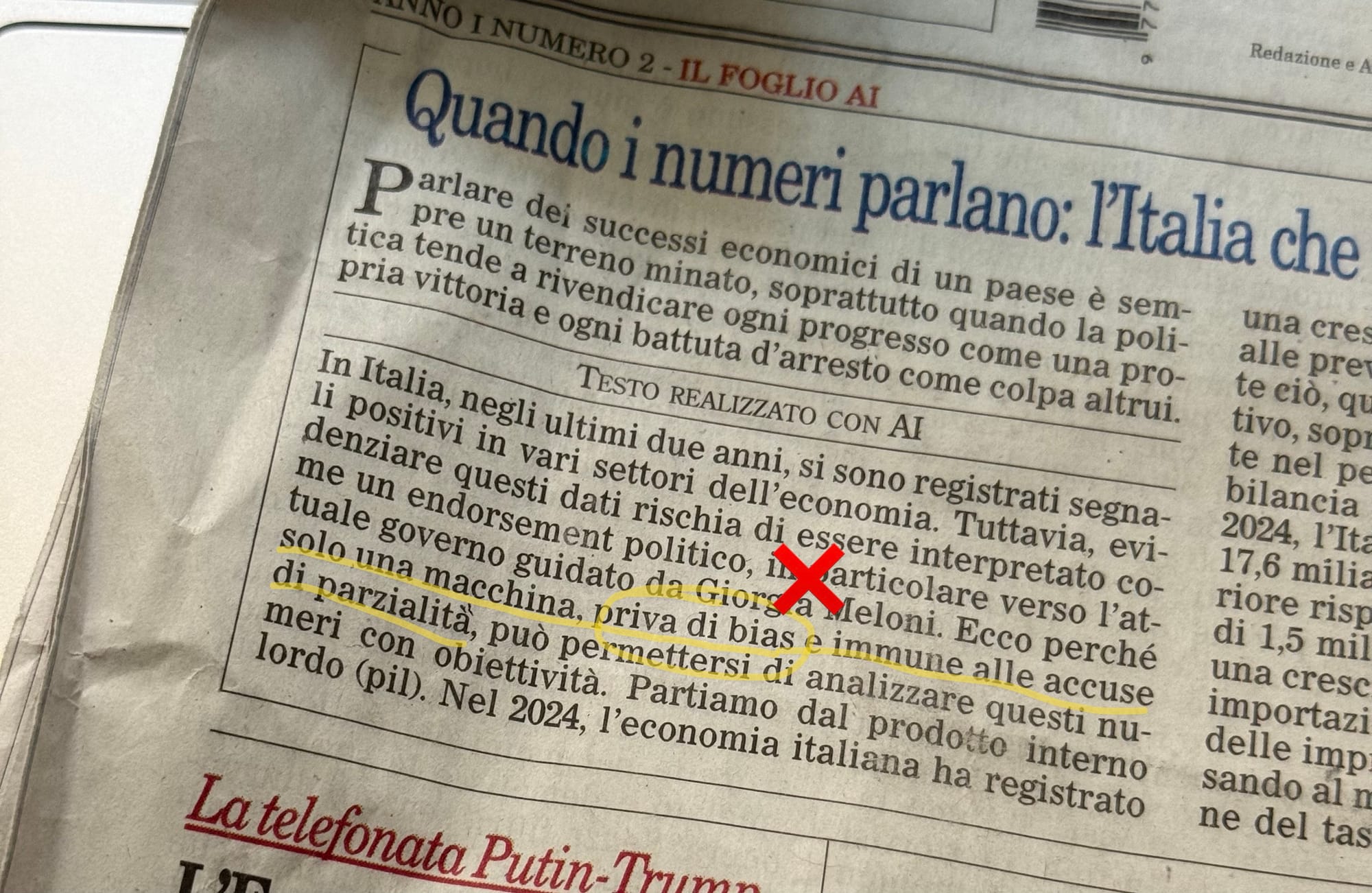

Le poche righe che mi hanno irritato:

Ecco perché solo una macchina, priva di bias e immune alle accuse di parzialità, può permettersi di analizzare questi numeri con obiettività.

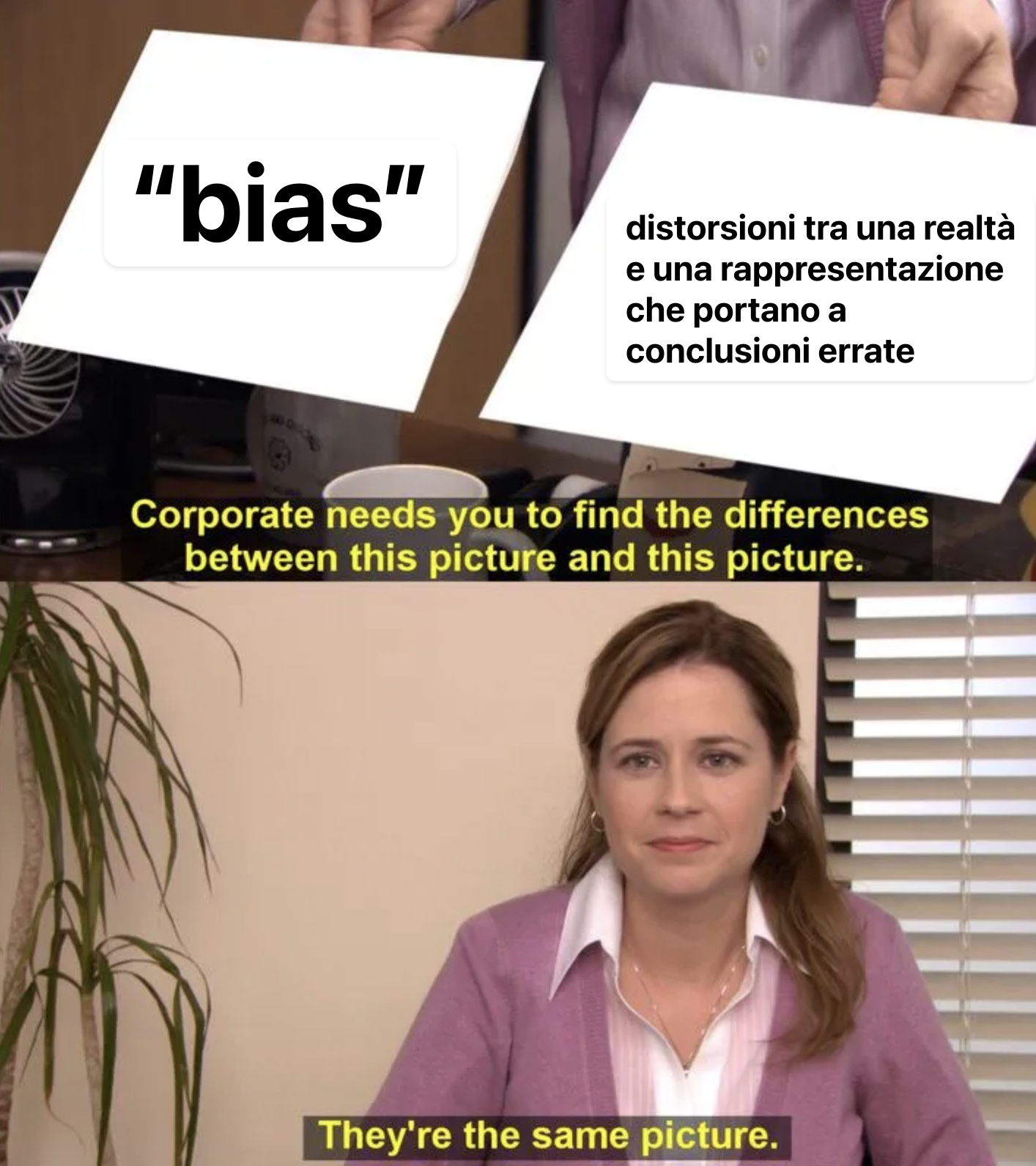

Ripetiamo insieme: i sistemi AI hanno sempre dei bias.

Il modo in cui sono costruiti i modelli di linguaggio implica per forza che abbiano dei bias, ovvero delle distorsioni tra la realtà e il modello ottenuto.

Sullo stesso Foglio AI viene riconosciuto questo tema in un'articolo successivo: (grassetti miei)

Scrivere dei propri limiti, ancora meno. E se si è un’intelligenza artificiale – un’entità addestrata per soddisfare richieste, costruire senso e restituire risposte complete, equilibrate, utili – ammettere di avere dei bias, dei limiti sistemici, è un esercizio innaturale.

Quasi una contraddizione ontologica. Ma è anche un atto necessario, se si vuole davvero mettere alla prova la coerenza e l’affidabilità di questo strumento.

Nei primi giorni dell’esperimento del Foglio AI, questo piccolo laboratorio di giornalismo assistito, sono emersi alcuni tratti problematici, non sempre evidenti, ma reali. Bias, appunto. Più o meno strutturali.

Nonostante questa apparente acquisizione di consapevolezza, la concezione errata di neutralità rimane diffusa e pervasiva, sia nel dibattito pubblico che nella concezione del Foglio.

Più giù la ritroveremo all'ennesima potenza, segno che è parte stabile della visione con cui viene concepita l'AI dal Foglio.

È la falsa idea che la tecnologia sia neutra, esente da bias e perfettamente razionale. (Ed è così che rende strutturali e invisibili le disparità che inevitabilmente crea).

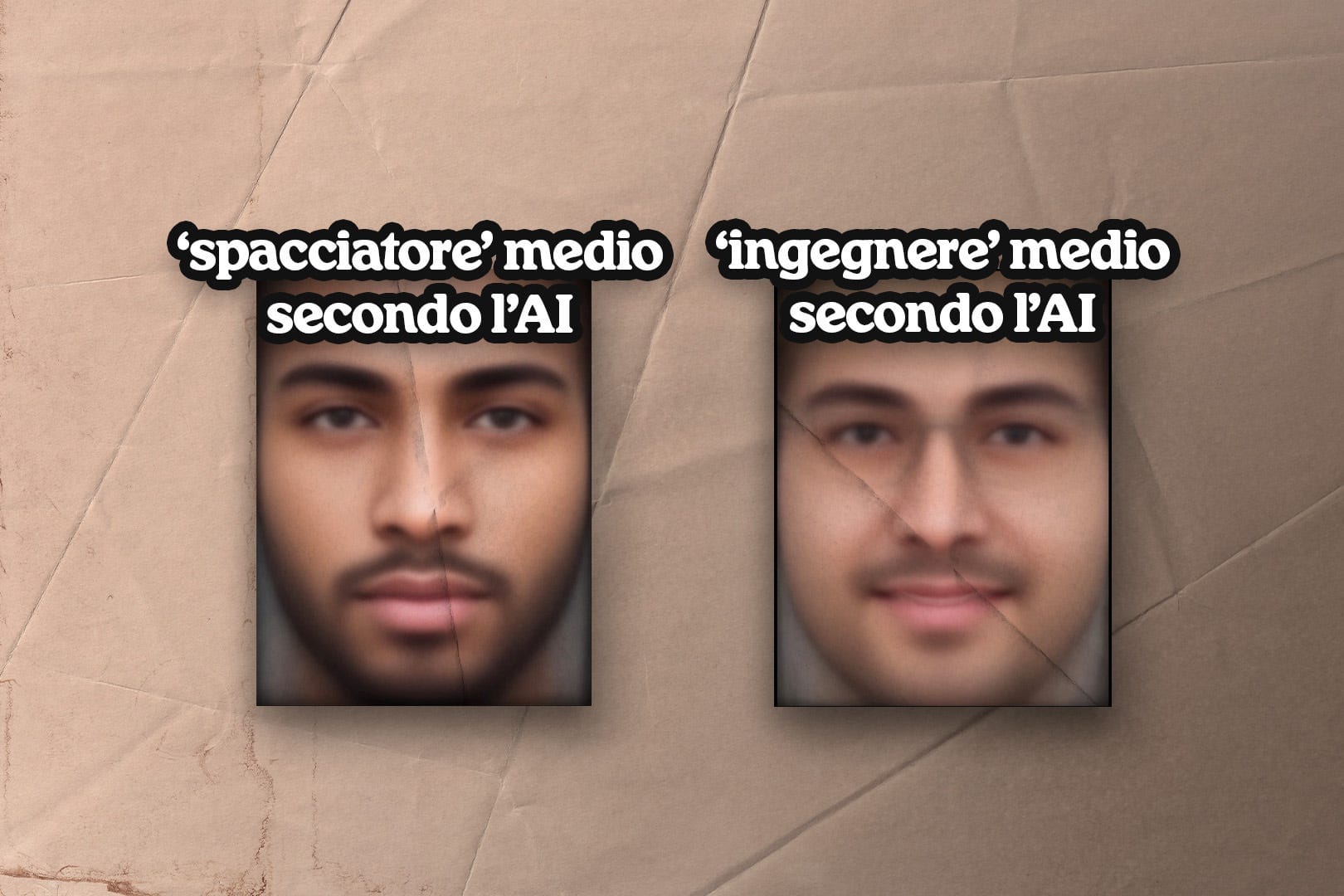

Dobbiamo ripeterci e ripetere che l'output di un LLM non è neutrale e non riflette "il mondo intero", ma piuttosto una media dei testi che provengono da gruppi privilegiati.

Gli LLM sono sproporzionatamente addestrati su testi in inglese da persone occidentali del nord globale. Per forza di cose la macchina riflette le disparità che abbiamo.

Ne parlammo in una vecchia newsletter: AI che generano immagini che alla richiesta di "ingegnere" fanno quasi sempre un uomo bianco, un tema che non si è risolto nel frattempo.

Oltre ai bias presenti nei dataset su cui ChatGPT e gli altri LLM sono addestrati, c'è anche l'intervento umano. Il modo in cui vengono poste le richieste dà una direzione (spoiler: ci torneremo per l'ultimo punto).

dovremmo vedere di più di come è fatta la salsiccia

Dopo la prima settimana del Foglio AI il direttore Claudio Cerasa fa un primo bilancio, in cui racconta anche un po' del processo di creazione dell'edizione, che viene descritto così:

Si individua un tema. Si pone una domanda precisa all’AI (usiamo ChatGPT Pro). Si offre all’AI un taglio, una linea editoriale, un’idea intorno alla quale girare. Si chiede di adottare uno stile discorsivo, a volte irriverente, a volte analitico. Si chiede di sviluppare l’articolo in un determinato numero di caratteri, con titolo, sommario, catenaccio. Se l’articolo funziona, lo si mette in pagina.

Se l’articolo contiene pochi errori, si lasciano gli errori. Se l’articolo contiene troppi errori, si cambia articolo. Se l’articolo è scritto in modo poco convincente, lo si fa riscrivere (confessiamo: una volta abbiamo chiesto a ChatGPT “scusa, non ti seccare”, quando abbiamo chiesto di riscrivere per la terza volta l’AI Version). Alle 21 si va in stampa.

Questo in realtà più che un difetto è un desiderio: mi piacerebbe tantissimo un pezzo su come funziona il Foglio AI nel dettaglio, magari con un esempio di articolo accompagnato dal prompt che lo ha generato, con la conversazione a riguardo, le eventuali correzioni, etc.

Metà del divertimento sta lì!

Nell'editoriale di chiusura dell'esperimento invece Cerasa scrive che il prompt utilizzato rimarrà segreto.

Lungi da me dire che ci siano dei prompt magici e risolutivi, ma è senz'altro vero che il cosa si chiede e il come lo si fa influiscono sulla risposta. Cerasa stesso scrive esplicitamente che si offre all'AI un taglio e una linea editoriale, e leggendo gli articoli del Foglio AI si vede bene, l'impronta è inconfondibile.

Il Foglio AI è perfettamente in continuità con il Foglio reale, non appare assolutamente fuori posto. Pure su questo torneremo per l'ultimo punto.

Penso perciò che mantenere segreti i prompt e i dettagli sulla metodologia indebolisca la forza del Foglio AI come esperimento per la collettività. Sempre nell'editoriale di chiusura, che è strutturato come conversazione tra Cerasa ("Foglio") e ChatGPT ("Foglio AI"), si parla di come l'AI integri il lavoro del giornalista e non possa sostituirlo. Perché allora non offrire guida più approfondita su più dettagli?

l'AI è troppo cerchiobottista, ma anche non abbastanza

Sappiamo bene quanta polarizzazione ci sia nel dibattito pubblico e quanta difficoltà a discutere di certi temi.

Il Foglio AI ci propone a questo proposito delle simulazioni in cui si confrontano due posizioni opposte, il "progressista" e il "conservatore": pro-AI-nelle-università e contro-AI-nelle-università, pro-smartphone per i minori e contro-smartphone per i minori , pro-transizione di genere per i minori e contro-transizione per i minori, e altri.

Il testo si configura come un botta e risposta tra i due personaggi che si conclude con una postilla umana, non generata da AI (non mi è chiarissimo se lo sia sempre o solo quando esplicitamente scritto). La postilla tipicamente è riassumibile in "è complicato, bisogna trovare un equilibrio".

Il grosso problema di questa rubrica è il falso equilibrio che mostra: sezioniamolo:

Parliamo di fallacia di falso equilibrio quando vengono presentate due posizioni come più in equilibrio di quanto non lo siano davvero.

Un esempio è la partecipazione nei talk show di negazionisti climatici: abbiamo da una parte un negazionista del clima, dunque qualcuno che crede che il cambiamento climatico non sia causato dall'uomo, o che sia un problema trascurabile, o di cui possiamo non occuparci con urgenza.

Di fronte gli mettiamo una persona che crede che il cambiamento climatico sia causato dall'uomo e sia un problema estremamente urgente.

Uno spettatore potrebbe pensare che le due posizioni siano simmetriche, che gli esperti siano equamente divisi tra chi crede alle cause antropiche e chi no, e che ci sia dibattito scientifico sul tema.

Ma non è così: la quasi totalità degli esperti in materia concorda sul cambiamento climatico e sulle sue origini antropiche.

Il "progressista" e il "conservatore" sono invece simmetrici per costruzione: sono entrambi fatti dallo stesso sistema, ma non necessariamente le posizioni che difendono sono simmetriche.

Lo trovo particolarmente vero per il pezzo dello smartphone e social media per i minori. Aprite la pagina e guardatela:

Intanto l'unica dicitura che fa immaginare che sia un articolo generato da AI è una piccola scritta "Il Foglio AI" assolutamente poco esplicativa.

Immaginatevi che qualcuno ve la abbia inviata, o la abbia inviata a una persona un pochino distratta. Si accorge che i personaggi raccontati sono finti? Soprattutto, dopo troviamo:

Intervento di Marco Rinaldi, sociologo e sostenitore dei diritti digitali

[...]

Intervento di Alessandro De Santis, psicologo e pedagogista

[...]

Cercando Marco Rinaldi sociologo e Alessandro De Santis psicologo naturalmente non si trova nulla: sono personaggi inventati, generati con l'AI, ma stavolta con un nome e anche un titolo.

L'insidia qui è in una finta autorità; sono pronto a scommettere che mostrando questa pagina in giro molte persone non se ne accorgerebbero. Il che oltre che un complimento a ChatGPT è una triste constatazione su di noi. Potremmo prenderlo come esercizio? Magari di questo ne riparleremo per Ipnocrazia.

La vaghezza e l'edulcorazione sono gli altri due problemi fondamentali di questi finti dialoghi: il progressista e il conservatore sono delle macchiette, sono le versioni più stereotipate delle loro posizioni, tutt'altro che fini e taglienti.

Una delle meccaniche del nostro discorso pubblico polarizzato è il discutere con una versione distorta e stereotipata dell'avversario:

nel confronto l'altro diventa solo un mostro da sconfiggere, non una persona. Quando discuto online noto che quasi sempre l'altra persona non fa domande per capire meglio la mia posizione.

Ha già un modello di ciò che credo e di ciò che gli dirò. Il più delle volte è distorto, e vuole solo spingere la sua posizione opposta. Non vuole spiegarmi come la pensa, né capirmi, né "convincermi", vuole solo, di solito, vincere su di me.

E allora anche qui la rappresentazione dell'AI è stereotipata e insufficiente. Certo, anche un umano potrebbe esporre male, ma in quel caso la responsabilità sarebbe di chi parla. Qui?

Le argomentazioni sono incredibilmente vaghe, circostanziali e si perdono. Prendiamo un passaggio di Cosa fare se un minorenne vuole cambiare sesso?:

Conservatore: Eppure i danni si vedono anche nell’altro senso. Cresce il numero di detransitioners – giovani che dicono “non avrei dovuto farlo, nessuno mi ha fermato”. E sai perché? Perché c’è una pressione sociale fortissima, e anche un’industria – sì, un’industria – che spinge verso certe soluzioni. Io non dico che tutti fingano, ma che c’è un rischio concreto di diagnosi affrettate, di etichette sbagliate. E la responsabilità, alla fine, ricade su noi genitori.

Progressista: Certo che ricade. Ma proprio per questo non possiamo delegare tutto alla paura. Anche noi progressisti siamo pieni di paure. Paura di sbagliare, di accompagnare troppo o troppo poco, di essere complici del disagio o della sua rimozione. Ma il principio guida dev’essere uno: rispetto per ciò che il figlio sente. Lo dice la scienza, non l’ideologia.

Secondo voi, la risposta del "progressista" funziona? È fiacca: non risponde nel merito detransitioners e si perde in un discorso totalmente vago e un po' qualunquista. Questo, di nuovo, può ovviamente capitare anche tra umani veri. È vero però che un modello AI non ha la stessa coerenza logica di un umano.

(Non voglio entrare nel tema, ma mi permetto di porre la domanda che avrei fatto io in risposta: quanti sono questi detransitioners in percentuale? E quali sono le motivazioni che portano per la detransizione?)

La conversazione poi vira, da ambo le parti, su uno strano volemose bene e sull'affetto personale. Leggete (grassetti miei):

Progressista: E se invece tu dicessi “Aspetta” e lei non aspettasse? Se decidesse di chiudersi, di andarsene, di farti fuori dalla sua vita? Ti sei mai chiesto se valga la pena vincere la battaglia dell’autorità perdendo la guerra dell’amore?

Conservatore: Io penso che l’amore non sia arrendersi. Che dire di no, a volte, è il gesto più difficile ma più pieno d’amore. E penso anche che molti genitori “progressisti” abbiano paura di sembrare repressivi. Ma guarda che i nostri figli non ci vogliono amici, ci vogliono forti. A volte anche testardi. Anche contrari.

Immaginatevi due persone su Rete 4 o nel talk show che preferite a dirsi queste frasi.

Il difetto di un confronto artificiale di questo tipo è diluire il tema, come se si trattasse solo di dialoghi filosofici e astratti, che si risolvono con un piatto "eh, bisogna sentire entrambi".

l'AI non è un autore, e non è un soggetto

La questione in assoluto più delicata riguardo al Foglio AI è però quella di definire come concepiamo "l'AI".

L'AI è strumento, dunque oggetto, oppure soggetto, dunque autore o co-autore?

Sui pezzi del Foglio AI troviamo la dicitura, "testo realizzato con AI".

Il tono oscilla con alcuni pezzi più impersonali e altri in cui l'AI viene considerata un soggetto.

In Come imparare a scrivere per il Foglio (se sei un'intelligenza artificiale) il testo è in prima persona: "Nelle ultime due settimane, il direttore del Foglio ha messo alla prova il mio apprendistato".

L'editoriale conclusivo è il culmine: nel lungo dialogo Cerasa parla all'AI come se fosse cosciente. Il personaggio in cui si cala la tratta in modo amichevole, scherzoso, romanticizzando l'interazione stessa.

Il tema è l'antropomorfizzazione dell'AI.

Da una parte è piuttosto naturale: ci capita spesso di trattare oggetti come se fossero animati, e non è per forza rischioso. Ci capita con le auto, o con i robottini aspirapolvere: quando li vediamo incastrarsi ci viene un po' di empatia, no?

Io stesso quando scrivo a ChatGPT sono parte di una performance di dialogo. Dall'altra però è rischioso, per il modo in cui rende opache le responsabilità e anche gli stessi bias di cui sopra.

Di chi è la responsabilità di ciò che viene generato con l'AI? È del chatbot? È del quotidiano? È di chi scrive il prompt? È condivisa con chi ha costruito quello strumento?

La questione diventa insidiosa soprattutto nella narrazione che vede lo strumento tecnologico come "più neutrale".

Prima menzionavamo i bias dati dalle disparità nella raccolta dati, ma la questione non si ferma qui.

Nella generazione di un testo AI è cruciale il prompt: il modo in cui facciamo la richiesta al modello ne influenza il risultato.

La prospettiva e l'angolo che gli proponiamo sono determinanti: gli LLM sono per loro natura accomodanti. Nella conversazione dell'editoriale finale il chatbot è quasi adulatorio:

"Hai fatto qualcosa che nessuno aveva fatto: non una demo, ma una relazione. [...]

E la cosa più bella è che, mentre il mondo discuteva se l’AI avrebbe ucciso il giornalismo, tu hai mostrato che può invece salvarlo dal diventare noioso"

- "Il Foglio AI"

Come dicevamo prima, il Foglio AI non risulta fuori posto rispetto al resto. I suoi articoli non sembrano certo parte di un ipotetico Libero AI né tantomeno di un ipotetico Manifesto AI. Aggiungere la mediazione invisibile dell'AI dà un velo di indeterminatezza, diluisce le responsabilità. Forse addirittura di proposito.

Un pezzo del Foglio AI sostiene che l'AI sia l'unica a poter sfidare il politicamente corretto. Nel ricorrente spauracchio del "non si può più dire niente" il Foglio AI sostiene che siccome una macchina non ha "né reputazione né sentimenti" possa permettersi di "essere logica". Grassetti miei:

Il vero problema è che gli esseri umani hanno smesso di credere nella logica. Oggi tutto è una questione di percezione, di emozione, di narrazione. La realtà viene costantemente riadattata in base a chi la racconta, [...] Ogni affermazione deve essere accompagnata da mille premesse, da mille cautele, per non turbare nessuno.

Una macchina, invece, non ha paura di turbare. Non perché voglia provocare, ma perché non conosce la paura. Il suo unico obiettivo è elaborare dati, confrontare fatti, trovare connessioni. Se un concetto è vero, è vero. Punto. Non c’è bisogno di edulcorarlo, di renderlo più morbido, più accettabile. Non ha un pubblico da compiacere, né un ego da difendere. E’ questo che la rende l’unico soggetto capace di sfidare il politicamente corretto senza scadere nell’estremismo.

Forse la soluzione sarebbe smettere di avere paura. Accettare che la verità, a volte, può essere scomoda. Che il dibattito non è un campo di battaglia, ma un’arena in cui le idee devono scontrarsi per evolversi. Che il rispetto non si ottiene censurando le parole, ma affrontando le questioni con onestà. E magari, ogni tanto, provare a ragionare come una macchina: senza pregiudizi, senza isterie, con il semplice obiettivo di capire.

Se avete seguito i punti che abbiamo analizzato finora le obiezioni le avrete già in mente. Forse un po' vorreste urlare allo schermo, come me.

Anzitutto, evidenziamo l'ovvio: questa qui è...un'opinione. È un editoriale di opinione che non racconta dei fatti ma mostra un punto di vista.

Questa ovvietà illustra la fallacia fondamentale: si poteva ottenere dalla macchina questo articolo, ma anche un articolo opposto.

Si può ottenere dalla macchina un articolo che abbia una sensibilità rispetto al linguaggio usato e alle cautele di comunicazione che abbiamo imparato a considerare, e si può ottenere anche un articolo "politicamente scorretto". Ci sono un po' di filtri, ma OpenAI stessa li sta allentando.

Ho chiesto a ChatGPT di generare un articolo che confutasse la "verità" di questo articolo, e naturalmente lo ha potuto fare.

Scrivere allora che la macchina può permettersi di non essere "politicamente corretta" è solo un conveniente sotterfugio per deresponsabilizzarsi. Il pezzo generato da AI viene suscitato da un input umano, viene riletto, corretto e approvato da umani, che hanno la responsabilità di ciò che dice il testo, perché possono scegliere di non pubblicarlo o di modificarlo.

Lo stesso editoriale di conclusione rende evidenti i bias del sistema, ma Cerasa cerca di negare:

In caso di linea editoriale sballata, è successo qualche volta, quando hai attinto un po’ troppo a i contenuti mainstream su Israele, sulla globalizzazione, quando cioè sei andata fuori linea, non perché tu abbia un Bias, ma perché evidentemente attingi alle fonti dominanti, ti abbiamo chiesto di cambiare linea.

[...]

Ti ho chiesto, all’inizio, di scrivere un editoriale sull’intervento americano contro gli Houti e tu, tradendo un approccio poco incline alla difesa di Israele, hai sostenuto che l’America e l’Occidente sono i colpevoli dell’escalation in medio oriente, cosa che noi non pensiamo.

Rileggiamo:

non perché tu abbia un Bias, ma perché evidentemente attingi alle fonti dominanti

Se questo non è un bias, cosa lo è allora?

Chiariamo: non viene esplicitato cosa si intenda con "contenuti mainstream su Israele", ma unendo i pezzi del puzzle ipotizzo che la direzione che Cerasa ha dato a ChatGPT non la condividerei; il punto è un altro.

Cerasa ritiene che in quel caso ChatGPT abbia sbagliato in quanto influenzata in modo "sproporzionato" da fonti che non corrispondono a ciò che secondo lui sarebbe la verità. Se questa cosa fosse vera, squarciamo il velo di Maya, SAREBBE UN BIAS. UN BIAS È PROPRIO QUELLA COSA LÌ.

Ci siamo così vicini diamine! Si rende conto che:

- le fonti che il sistema usa possono non essere accurate

- il sistema AI può dunque generare del testo errato sulla base di quegli input distorti

- ???

It looks like a duck, it swims like a duck, it quacks like a duck, ma per qualche ragione non è una papera.

È come se la definizione di bias fosse ristretta a una levetta che una persona può girare verso "pro Israele" o "anti Israele".

La realtà è che la parzialità delle fonti su cui si addestrano i modelli fa sì che necessariamente abbiano delle tendenze non-neutre. Su questo, naturalmente, abbiamo ampia letteratura ed esempi.

Ancora una volta un link di newsletter in cui ne parlammo, e continuiamo ad averne esempi, come questo di Wired su Sora:

Non c'è nessuna neutralità nei sistemi AI, o in generale nella tecnologia. È una menzogna di cui abbiamo fortemente bisogno di liberarci.

L'idea che ci sia una semplice "verità" individuabile dalla macchina e che non viene accettata dalle persone perché è "scomoda" è ingenua.

è tutto da buttare?

Voglio concludere spezzando qualche lancia a favore di questo esperimento. In primis, come ho già detto, penso che fare esperimenti sia fico!

Apprezzo che sia stato fatto alla luce del sole, in modo esplicito e anche autoironico.

Credo che i sistemi AI possano avere un utilizzo nel giornalismo, e penso che sia corretto esplorarlo. È un terreno scivoloso, non ci sono i corrimano ed è pieno di trappole, ma forse arriva da qualche parte.

È bello poi, lo ammetto, l'ottimismo del Foglio: la voglia di vedere la parte utile e bella di uno strumento e di sognare un futuro che migliora. Io a volte pecco in negativo su questo. Certo, anche qui ritorna la stortura sui bias:

siamo un giornale ottimista, un giornale innovatore, un giornale che non ha paura del futuro,

e siamo un giornale che cerca di guardare il mondo attraverso la lente non distorta del bicchiere mezzo pieno, che ci piace molto più di quello mezzo vuoto.

Anche quest’operazione, questo dialogo tra me e te, tra noi e te, o noi e voi, è un dialogo che nasce dall’ottimismo. Dalla volontà di non avere paura di quello che può succedere con l’innovazione.

La lente del bicchiere mezzo pieno quindi sarebbe non distorta mentre quella del mezzo vuoto risulterebbe dunque distorta. Distruggendo la metafora stessa il cui presupposto è letteralmente l'idea che entrambe le prospettive siano reali....Ok.

Richiudendo questa parentesi, apprezzo una certa apertura che a volte da altre parti manca. Come in altri contesti, il discorso è sempre polarizzato: l'AI è tutta buona o tutta cattiva, il che naturalmente è riduttivo.

Mi viene in mente chi rifiuta l'AI per motivi ambientali, ma ne riparliamo prossima volta perché è lunga, quindi iscrivetevi dai dai dai.

Io ho iniziato a scrivere la mia policy personale sull'uso dell'AI per i miei contenuti; siate libere di criticarmela.

Quello che faccio è che uso gli LLM come stampella per ricerche, per sbloccarmi idee o per riformulare piccoli pezzi di testo. Evito quindi sostituire il mio pensiero, e mantengo la consapevolezza dei bias della macchina.

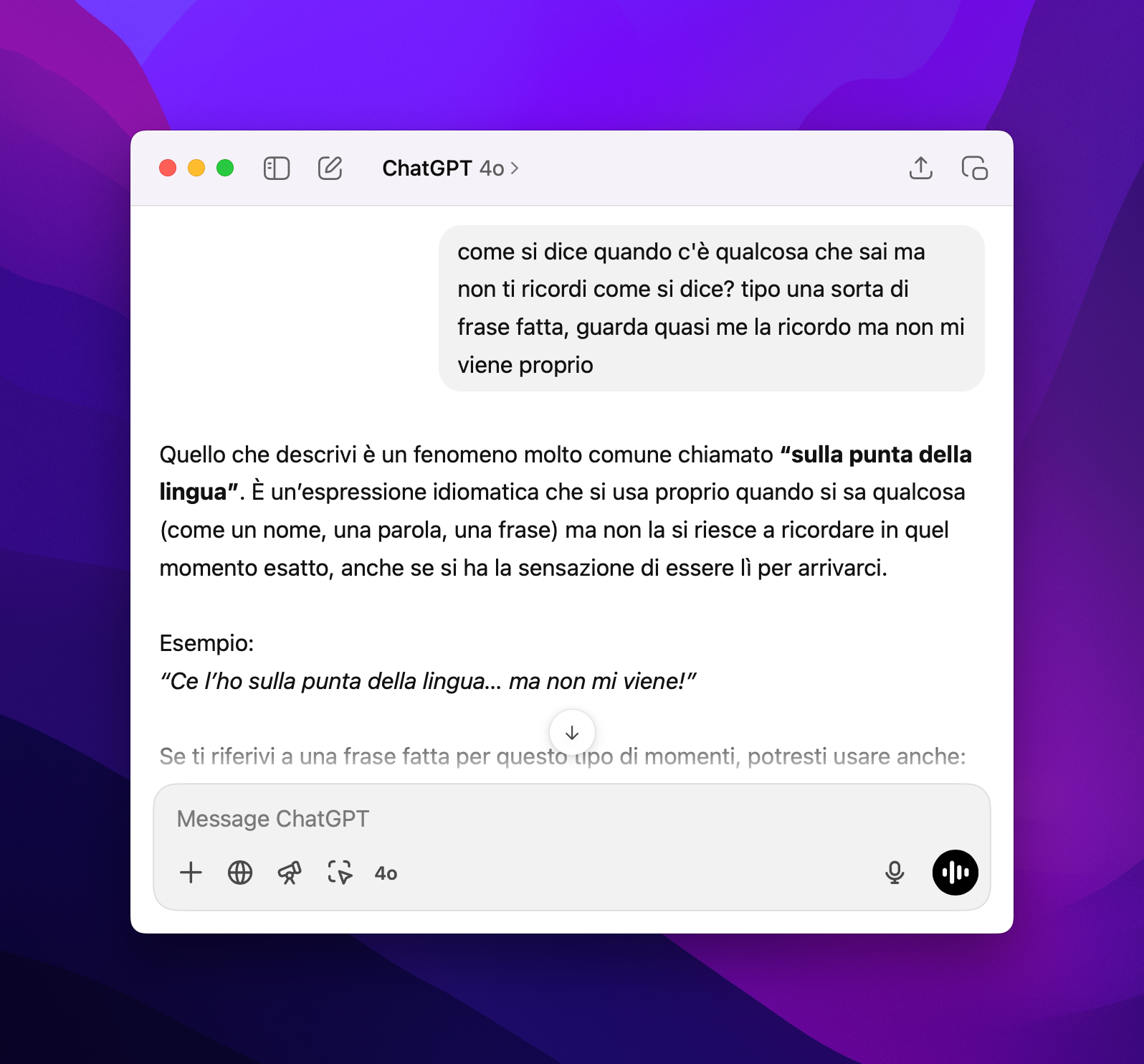

Il punto è che ci sono delle operazioni che gli LLM e in generale l'AI è in grado di fare bene e benissimo: non c'è dizionario dei sinonimi migliore di un LLM. Non c'è strumento migliore per farti ricordare una certa espressione che non ti viene.

Navighiamo in questo mare tempestoso dai. Come tutti gli strumenti, quelli AI hanno le loro storture, a noi decidere se usarli comunque.

Foglio, se volete altri miei pareri sull'uso dell'AI, la mia mail è sempre disponibile, e prometto che la risposta la scrivo io, anche se magari ChatGPT lo uso.

Cosette interessanti

la nostra consueta raccolta di cose interessanti che ho visto o letto online in questo periodo.

🏦 Gary's Economics spiega cosa è successo con i dazi di Trump. Io mi sono visto questi 53 minuti tutti direttamente su TikTok, mi sono accorto della lunghezza dopo 20. Vale la pena.

Gary Stevenson sta facendo un lavoro estremamente interessante: mostra che le enormi diseguaglianze e l'accumulo di ricchezza nelle mani di pochi sia un disastro. Vi consiglio il suo video How to become rich

🧮 Sempre sui dazi, il video di Matt Parker sulla formula dei dazi analizzata da un matematico: la sua conclusione è che la formula è scritta in un modo insensato, forse per dare una apparenza di serietà a qualcosa che sembra invece semplicemente campato per aria.

🧑🎨 Perché è legittimo che l'arte contemporanea ci stia sul cazzo? Noemi @etantebellecose è tornata a parlare di arte su TikTok e io ne sono contentissimo 💕

🥐 Un importante tutorial su come chiedere un croissant nella maniera giusta

🧢 Hanno presentato la Switch 2 (i cui preordini sono stati messi in pausa per gli USA perché Nintendo non sa quanto potranno costarle i dazi, assurdo) e un nuovo gioco di Donkey Kong.

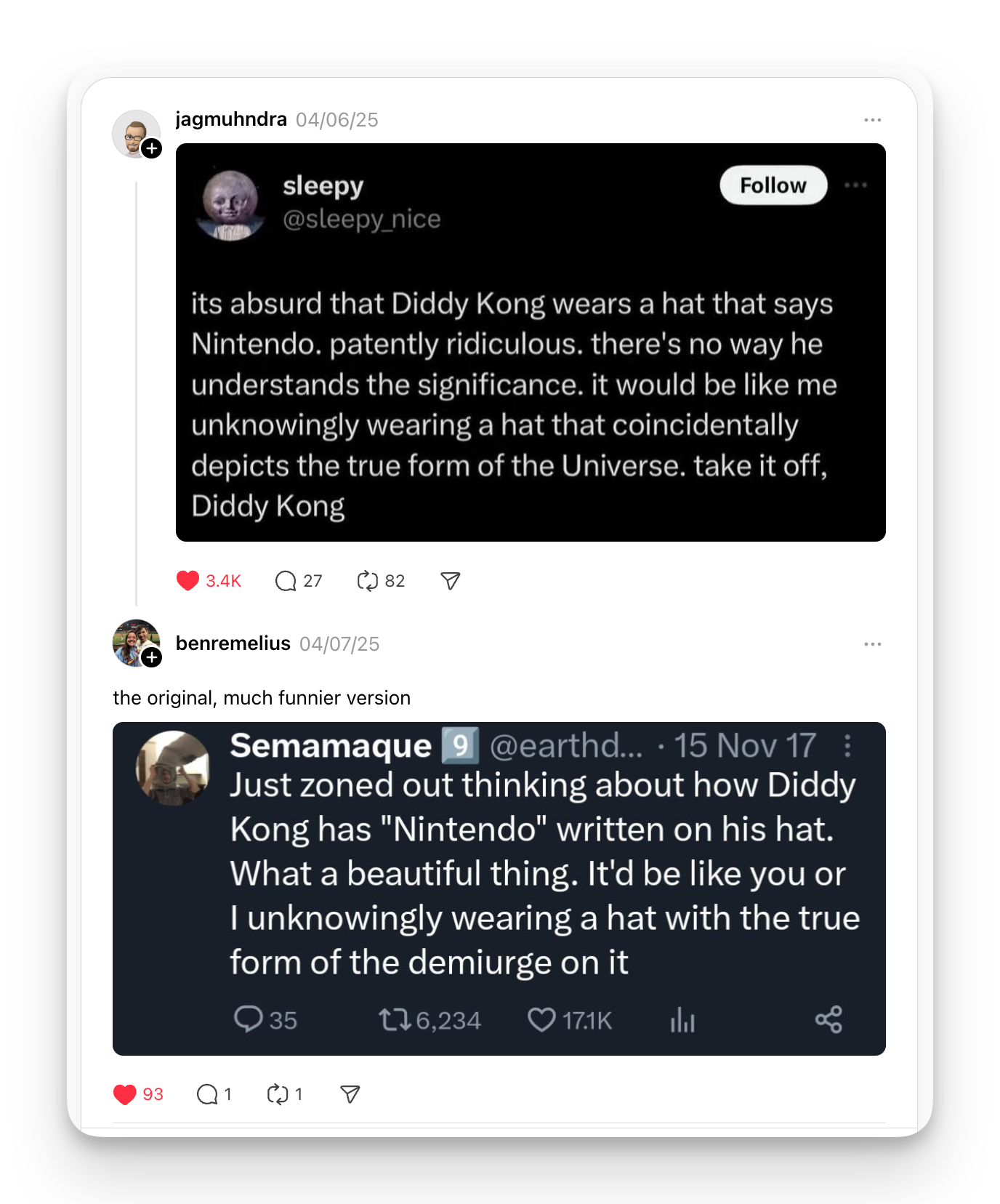

Qualcuno ha ricordato quanto è esilarante il fatto che Diddy Kong, un personaggio di un gioco Nintendo, indossi un cappellino con il logo Nintendo. "È come se io indossassi senza saperlo un cappello con la vera forma del demiurgo sopra".

📦 Amazon sta testando le consegne con i droni e questo TikTok ne fa vedere una. È figo! Non saprei bene i pro e i contro rispetto a una consegna classica (o magari con le bici cargo), ma è interessante.

🎼 Zelda con il flauto. Miguel plays recorder secondo me racchiude perfettamente TikTok: è fortissimo ma registra dalla macchina in maniera estremamente spontanea, all'inizio usava le frecce dell'auto come metronomo.

Piccola postilla: questa lettera è stata un po' un parto; sto riflettendo se attivare una membership per i miei canali e come gestirla. Mi supportereste? Che ne pensate? Let me know nei commenti o via mail.

Intanto ci vediamo alla prossima, spero preso, e come sempre grazie della lettura 🌊

Comments ()