Google ha *di nuovo* mandato una pubblicità sull'AI con un errore, e dai su.

Google manda una pubblicità sull'utilità di Gemini. Il testo generato ha un errore, ma un dipendente Google dice che non è una allucinazione...

Come è possibile che capiti così spesso raga.

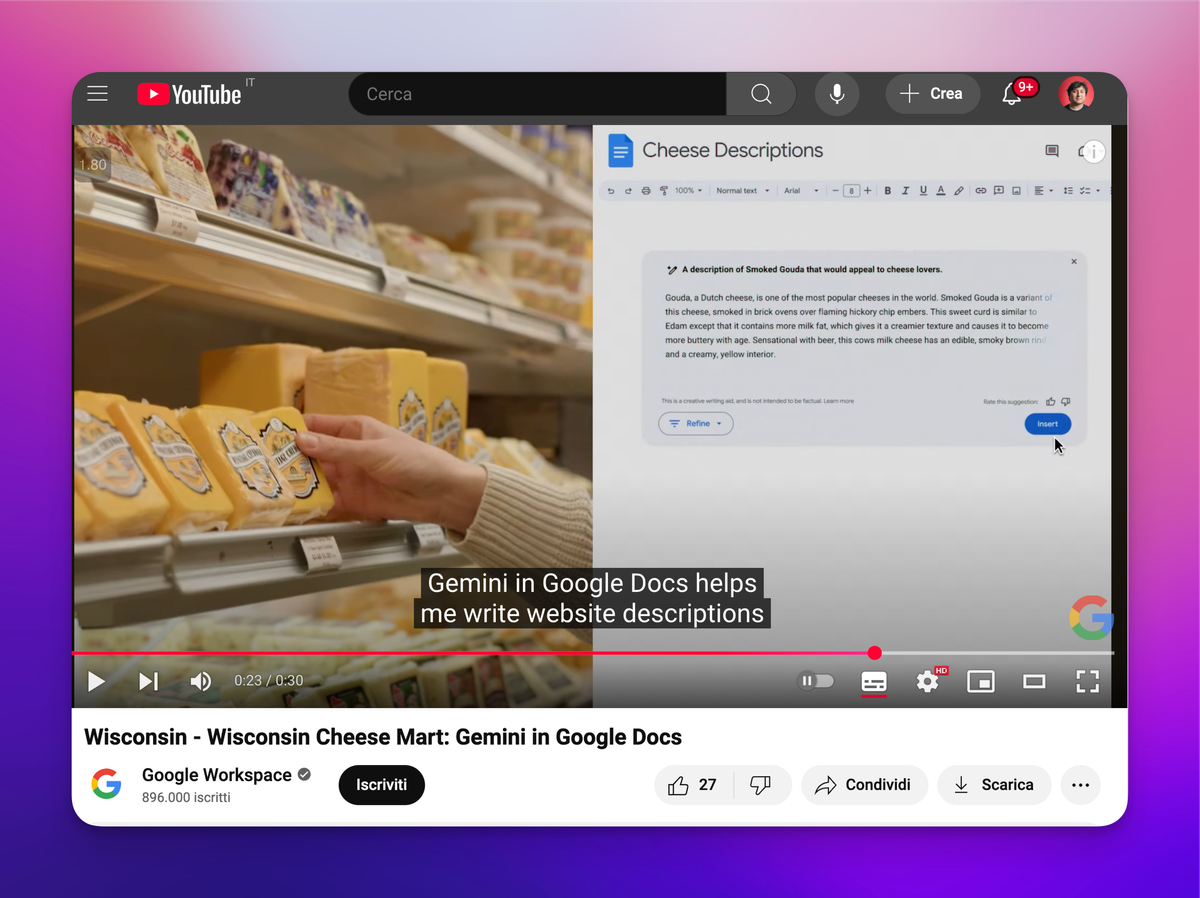

Allora, Google ha fatto una serie di pubblicità per il Super Bowl per mostrare quanto la sua AI Gemini sia utile per gli small business: il Wisconsin Cheese Mart è un esempio di negozio locale che vende molto online e che ha bisogno di un bel sito.

E quale modo migliore di avere un buon sito che riempirlo con AI slop del copy generato con AI usando Google Gemini?

(In realtà capisco che ci siano effettivamente delle occasioni in cui il testo generato con AI ha una funzione. È vero che a volte ti serve davvero del testo "filler"; allo stesso tempo mi chiedo se sia una necessità artificiosa. C'è una quantità di fronzoli e formalità che sopportiamo anche se non sarebbe sempre funzionale, no? Ma è un pensiero per un altro momento).

In ogni caso è sicuramente certo che bisogna sempre ricontrollare l'output di un LLM, per forza.

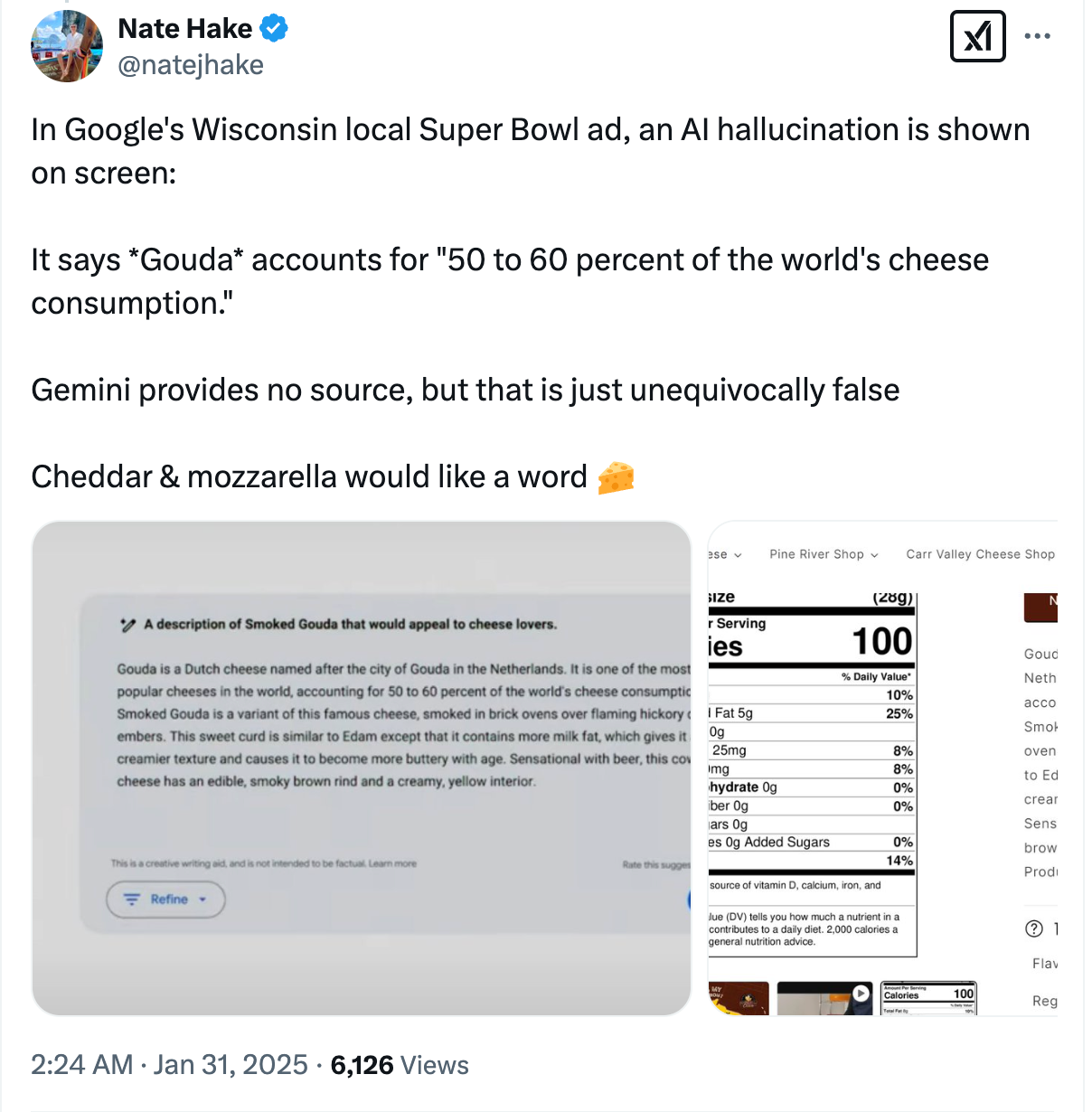

Ecco, Nate Hake ha notato su Twitter che nella pubblicità Gemini avrebbe generato del testo che dice che il Gouda fa "tra il 50 e il 60% del consumo mondiale di formaggio". Che ovviamente non è vero.

Sono più di 2 anni dalla diffusione ampia degli LLM come GPT e non abbiamo ancora all'orizzonte una soluzione robusta alle "allucinazioni". In parte perché quello che interpretiamo come allucinazioni è parte del funzionamento stesso degli LLM, del loro modo di generare testo.

Come il famoso articolo "Sui Pericoli dei Pappagalli Stocastici" di Bender et al. aveva sapientemente previsto: "la coerenza è negli occhi di chi guarda": quando un LLM risponde correttamente a qualcosa è inevitabilmente in parte...una coincidenza.

Attenzione, non intendo che gli LLM abbiano un output casuale: sono dei sistemi sofisticati fatti in modo da essere spesso corretti; quello che però intendo è che non c'è intenzionalità e consapevolezza da parte del sistema di quale sia la realtà, dunque non c'è la certezza sistematica della correttezza. E quindi, l'output deve essere controllato. Sempre.

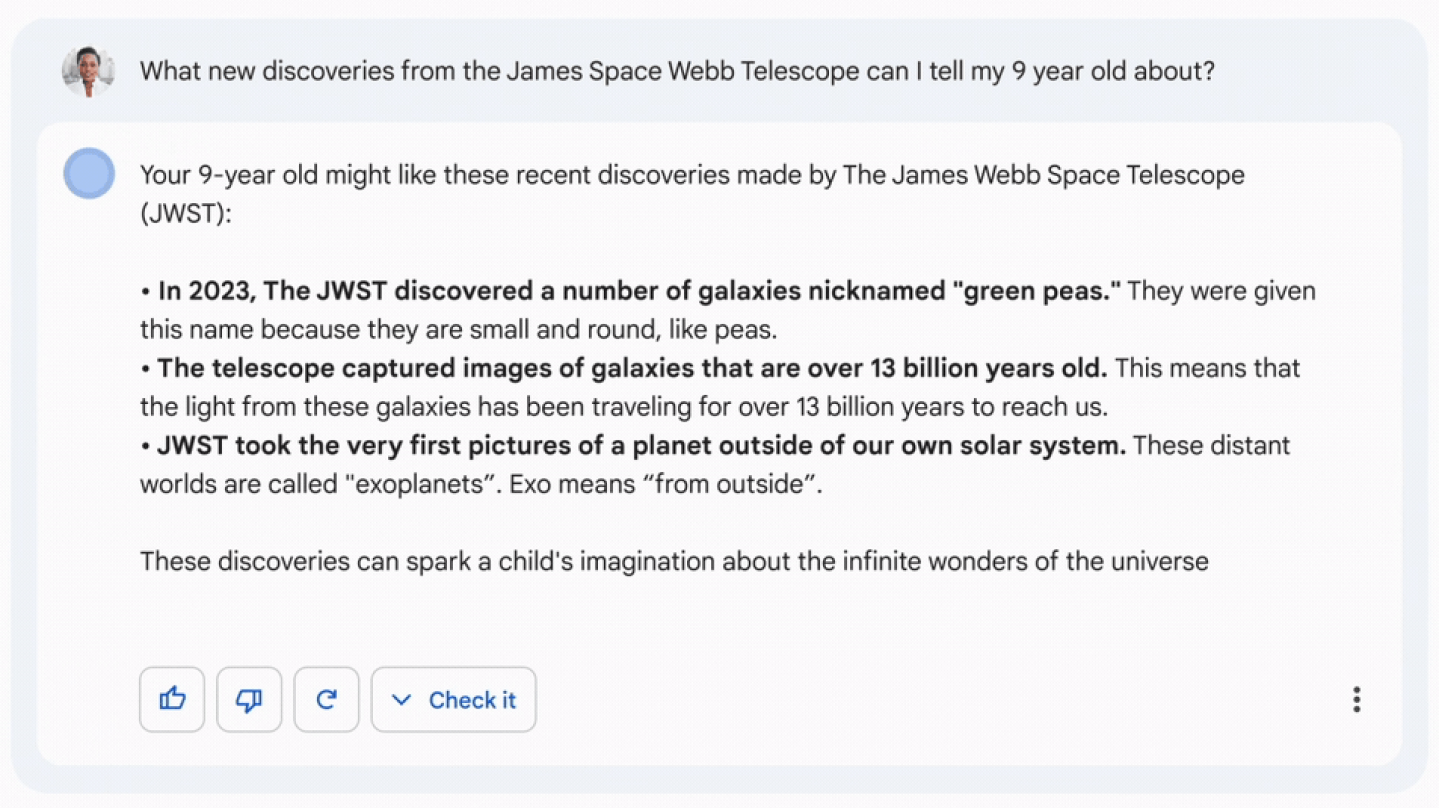

E mi fa molto ridere che Google evidentemente non se ne sia ancora accorta, perché non è la prima volta che gli succede. Ricordate Bard? L'assistente AI precedente a Gemini? Nella sua primissima demo pubblica c'era un errore: Bard aveva generato testo che diceva che il telescopio James Webb era stato il primo a scattare foto di un pianeta fuori dal nostro sistema solare, che, di nuovo, è falso.

Raga ma come è possibile? Come è possibile che "controlla l'output dell'LLM se ha errori" non è tipo la prima cosa che viene fatta per una pubblicità che vedranno in milioni di persone?

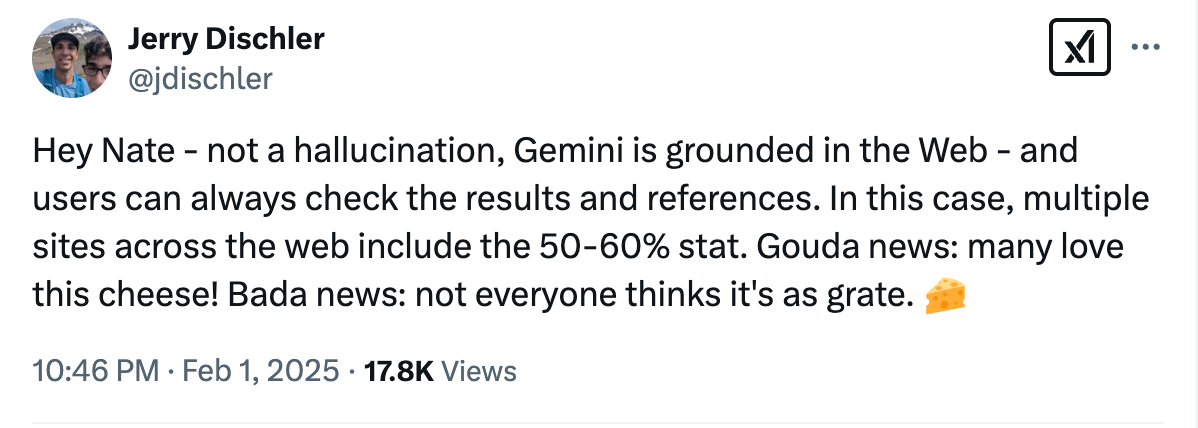

Ma non finisce qui! Jerry Dischler, presidente di Cloud Applications in Google Cloud, risponde che molteplici siti sul web includono questa statistica, quindi "non è un'allucinazione".

Sinceramente mi sembra una risposta un po' naive, perché non risolve la questione dei sistemi basati su LLM, ma anzi ne evidenzia ancora di più le lacune.

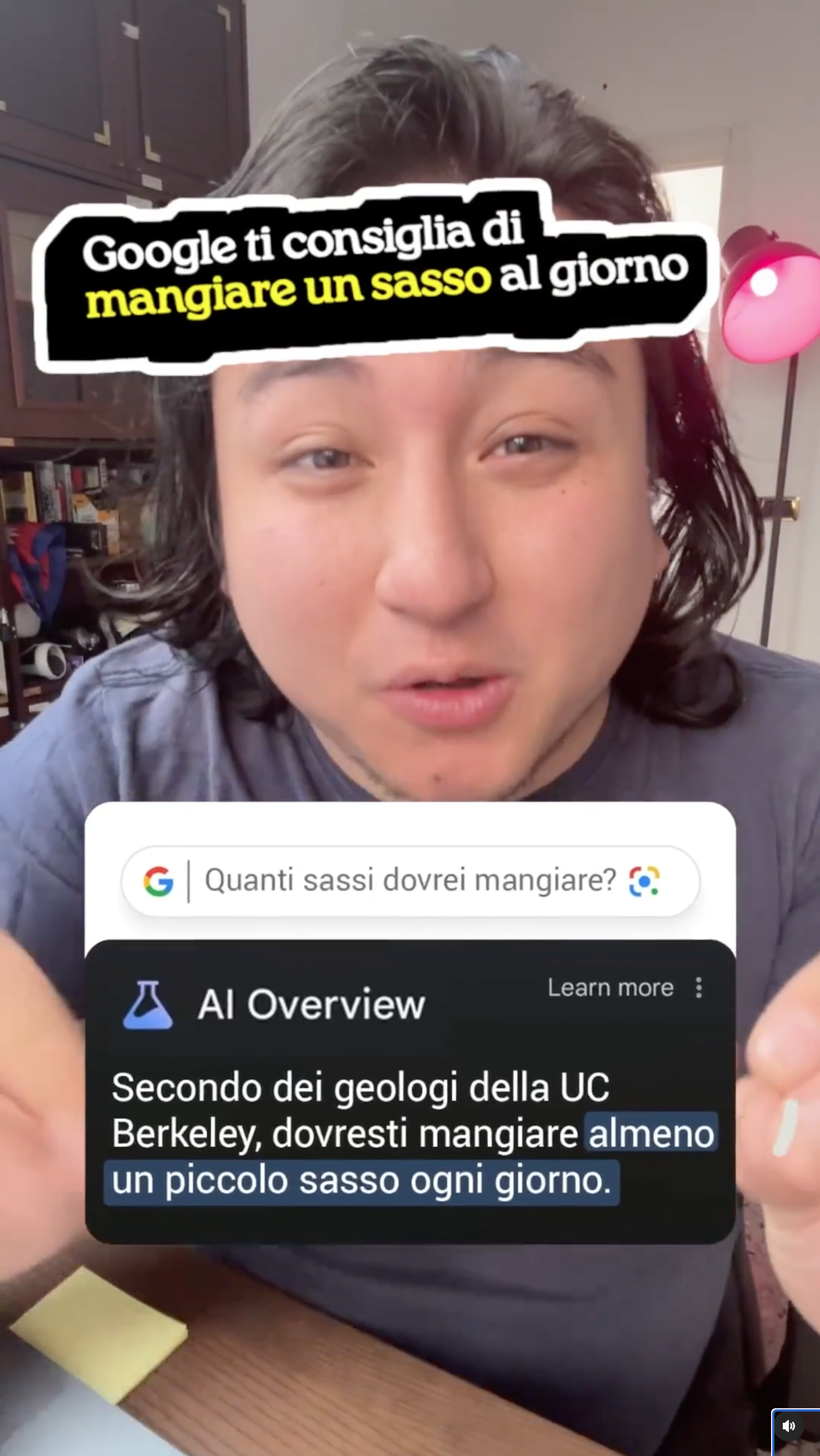

Il fatto che Gemini sia "basato nel web" è parte del problema: vi ricordate quando le risposte AI di Google avevano suggerito di mangiare un sasso al giorno o di mettere la colla nel sugo per far attaccare il formaggio meglio alla pizza?

Questi sistemi sono perfetti per reiterare miti comuni che vengono ripetuti spesso online, ed è precisamente perché si basano sui loro dati di training.

Sembrano permetterti di rimuoverti dalla responsabilità di scrivere qualcosa ed esserne cosciente, ma è un'illusione, perché la responsabilità del contenuto è sempre lì, è sempre tua, e il fatto che questi strumenti rendano più facile il nasconderla sotto al tappeto è un problema.

(Naturalmente Google ha modificato la pubblicità su Youtube in modo che l'errore non compaia più).

MA!! Non finisce nemmeno qui?? Emma Roth riporta su The Verge che il testo incriminato sul Gouda era sul sito dal 2020, come mostra il sempre prezioso Internet Archive, quindi...hanno finto l'AI? Era sempre stato un testo umano??

Capisco che tutte le pubblicità abbiano un po' di artificio dietro, è corretto, ma questa mi sembra una conclusione ancora più divertente.

Che ne pensate? 👇

Comments ()